點擊上方藍字

慣例,先問大家幾個問題:

你是不是發現,給 AI 喂資料,要么一篇一篇喂,要么一篇一篇粘到文檔里再喂,費時費力?

你想要分析競對的 blog 文章,數一數,是不是發現有幾十,甚至幾百篇?抓取內容是個大問題?

你想要分析競對的 top pages 內容,是不是發現你只能一個個點鏈接進頁面去看?

…

出現這些問題,是因為我們缺少高效抓取和整合內容的手段。

好消息,今天就給大家分享一個免費的自動化工具,可以一鍵抓取 url 內容并直接生成 PDF 文件。

你只需要花幾分鐘確定抓取內容,抓取和收集過程交給這個工具,拿到結果最后交給 AI 處理,非常省事。

另外,這個工具能夠幫助 AI 寫作更好地符合 EEAT 原則。

照顧到不懂的朋友,簡單解釋下什么是EEAT:

EEAT(Experience、Expertise、Authoritativeness、Trustworthiness),是谷歌評價網站內容質量的重要框架,而質量一直都是谷歌排名的核心環節之一。雖然不是 Google 算法中的直接排名因素,但這方面做得好谷歌會更信任你,對你的排名就更有利。

AI 寫作很容易遇到杜撰和抽風問題,它的數據庫里什么內容都有,不一定準,實時檢索有時候也會引用錯誤內容,這對 EEAT 來說是不友好的。

想解決這個問題,你就要給它優質信息庫,再通過 prompt 或者專門做一個 gpt bot 來嚴格指導它。

這個工具能夠加速你搭建信息庫的整個過程,庫搭好了,實現 EEAT 就完成了一半。

好處很多,還需要你到手實際體驗,那么我們廢話不多說,直接進入正題。

工具操作步驟:

1. 復制腳本,并按照如下視頻示意操作:

2. 等待 Import Libraries 加載完成,然后來到 File Input,點擊 Choose Files 上傳帶有你 url 的?csv 文件;

3. 腳本會自動生成并下載 PDF 文件;

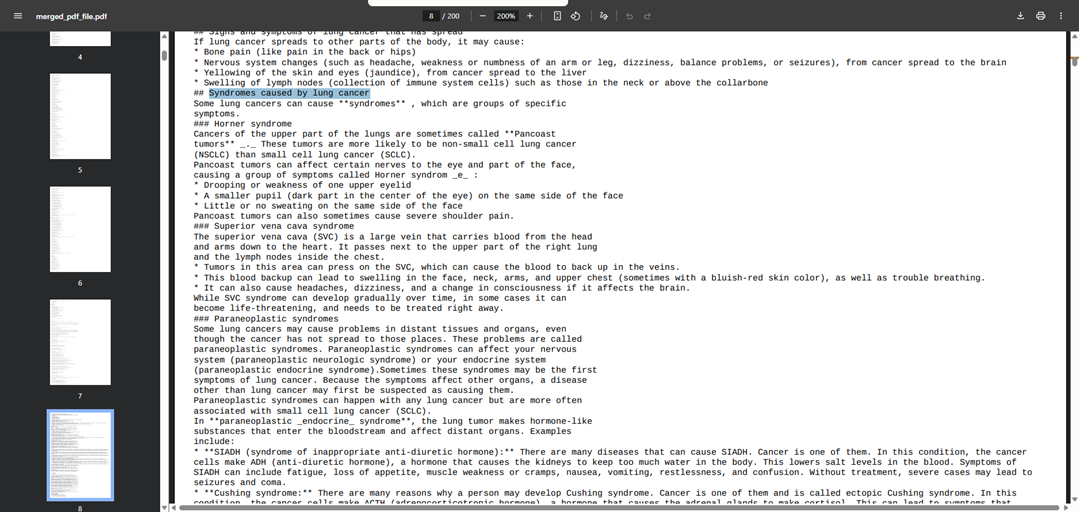

4. PDF 內容效果如下:

5. 步驟結束,很簡單。

*6.?在線腳本鏈接和本地腳本,獲取方式見文末;

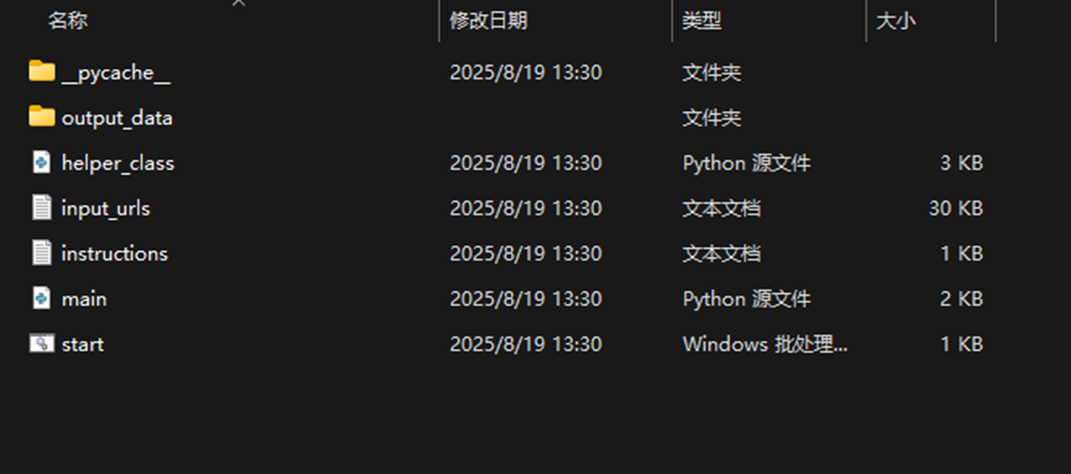

本地腳本

一些提示

很多地方都能用的上這個腳本,比如說:Screaming Frog Crawl、站點地圖(sitemap)、Ahrefs top pages、搜索結果頁,等等。用途非常廣泛,能夠為大家節省非常多的時間。

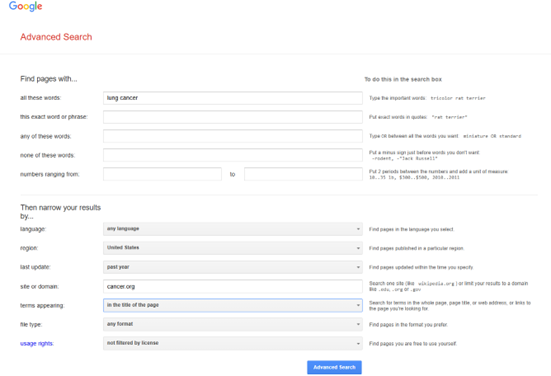

演示上傳的文件,是我們使用谷歌高級搜索,從 ACS (American Cancer Society)上快速獲取的,關于肺癌的權威文章。

演示文件我們會附在文末,工具大家拿到手可以快速試一試。

注意 GPT 上傳文件大小的限制。如果你要抓一整個網站,最終生成的 PDF 文件大小很有可能超出 GPT 的限制,這種情況你就需要使用一些在線工具先將 PDF 拆分才行。

這篇文章要分享的就是這些。

如果你覺得內容對你有幫助,點個贊,幫忙轉發給有需要的人。

類似的文章我們固定每周二分享 5-8 篇,如果你不想錯過,別忘了置頂本服務號,訂閱后右上角省略號即可置頂。

我們下一篇文章再見。

自動化工具獲取方式:

服務號對話消息輸入關鍵詞“自動化工具”,點擊實用資源可以查詢其它實用資源。

左下角閱讀原文獲取演示上傳文件的 Google sheet。

文章為作者獨立觀點,不代表DLZ123立場。如有侵權,請聯系我們。( 版權為作者所有,如需轉載,請聯系作者 )

網站運營至今,離不開小伙伴們的支持。 為了給小伙伴們提供一個互相交流的平臺和資源的對接,特地開通了獨立站交流群。

群里有不少運營大神,不時會分享一些運營技巧,更有一些資源收藏愛好者不時分享一些優質的學習資料。

現在可以掃碼進群,備注【加群】。 ( 群完全免費,不廣告不賣課!)