本篇筆記不是新聞視角,而是新聞背后的 HOW TO DO STEP BY STEP.

額,為什么單獨把Robots.txt協議拿出來研究?Shopify CEO Tobias Lütke上個月19號發了個推,如下圖:

對了,Tobias Lütke 剛剛入選了《2021年最佳CEO榜單,巴倫周刊》

當時,我看到這個推的時候,也是一臉懵逼?到底怎么編輯?為什么要編輯?不編輯可不可以?SEO小bai滿臉的問號。

額,下面的篇幅,則是看起來好像沒啥直接用處的,可能會有些枯燥的技術知識點。對于,越是模棱兩可的知識點,我越是有顆好奇心探究,所有看似零碎無序的線索,最后匯聚到一起融會貫通的時候,我相信,絕對不是巧合!萬丈高樓平地起,輝煌只能靠自己(這歌誰唱的。。。真的好土)?

本篇筆記,本來應該放到SEO公眾號的,這次顯得有點不夠嚴謹。入選的唯一牽強理由,也許和Shopify老大那條推有關把:D

什么是Robots.txt文件?

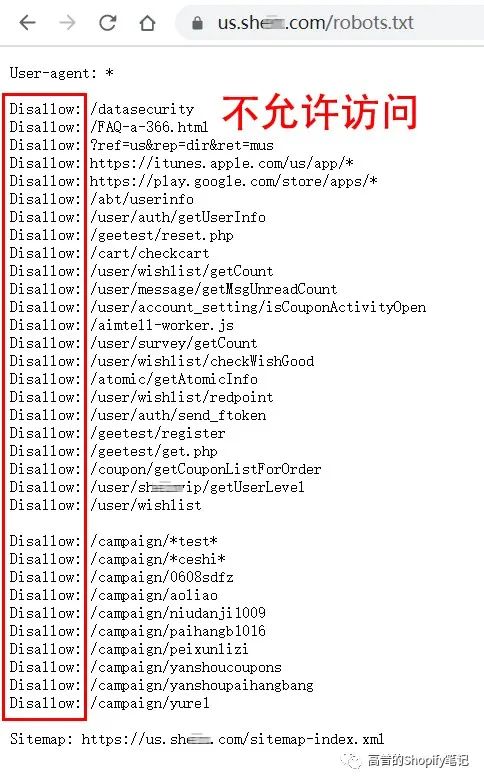

Robots.txt 文件是我們向 Google、Bing等其他搜索引擎爬蟲提供有關抓取哪些網頁和資源以及不抓取哪些網頁和資源的說明的地方。

robots.txt 文件通常會指示網絡爬蟲不要爬取內部管理或登錄頁面。

某in/robots.txt

本來想到的是拿spaceX來舉例,結果https://www.spacex.com/robots.txt 不顯示,不知道怎么回事。如何實現的?求大佬告知!

Robots.txt文件位于什么地方?

robots.txt 文件位于 Shopify 店鋪主域名的根目錄中。https://us.a*ker.com/robots.txt

Robots.txt由哪幾個部分組成?

User-agent:

Disallow:

Sitemap:

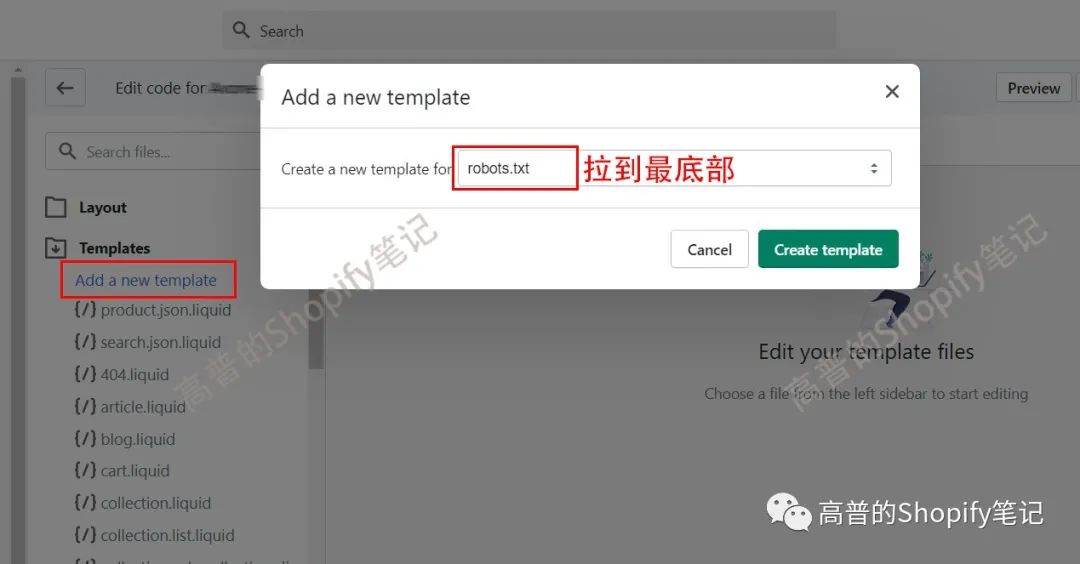

所有 Shopify 店鋪都有一個默認的 robots.txt 文件,但是,如果想對默認文件進行更改,則可以添加 robots.txt.liquid 模板以進行。

可以對Robots.txt文件進行哪些編輯?

1. 允許或禁止某些 URL 被抓取

2. 為某些爬蟲添加抓取延遲規則

3. 添加額外的網站地圖 URL

4. 阻止某些爬蟲

再具體點,如何操作?

首先新建一個robots.txt.liquid文件

如圖:

新建的robots.txt.liquid文件

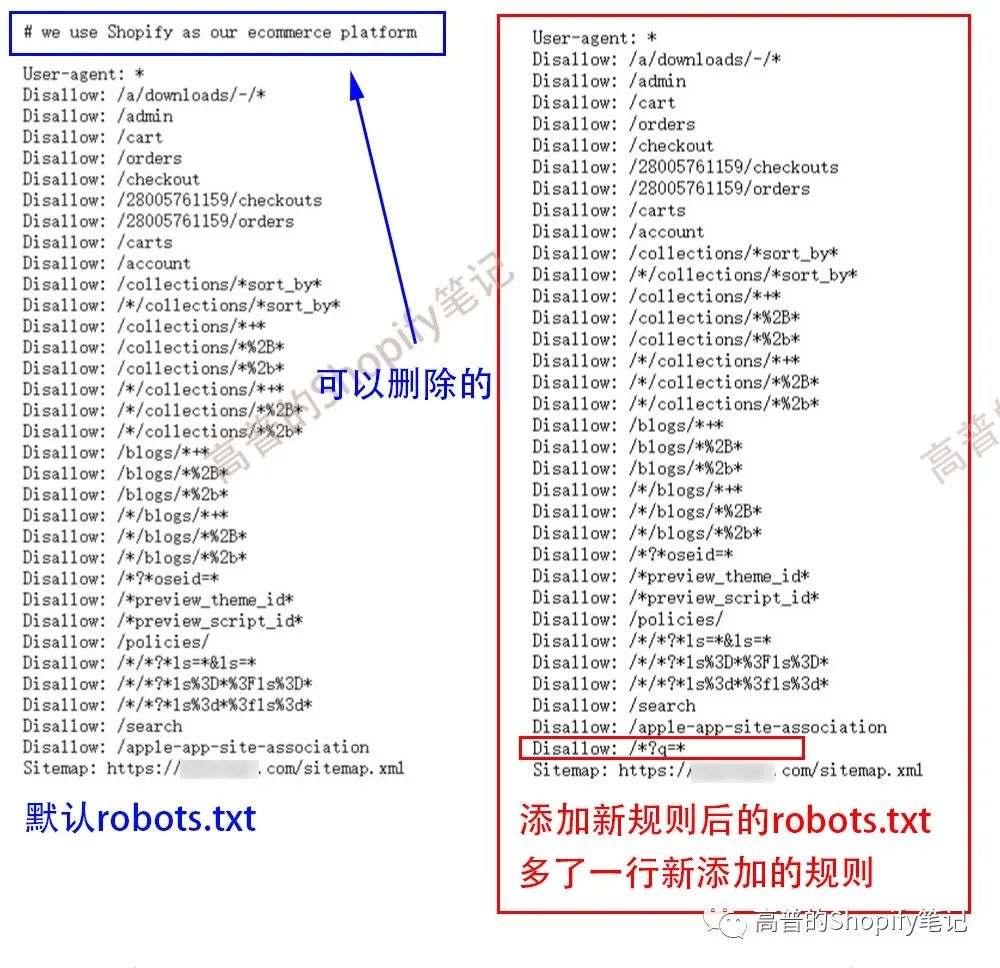

編輯1:Add a new rule to an existing group 向現有組添加新規則

{% for group in robots.default_groups %}{{- group.user_agent }}{%- for rule in group.rules -%}{{ rule }}{%- endfor -%}{%- if group.user_agent.value == '*' -%}{{ 'Disallow: /*?q=*' }}{%- endif -%}{%- if group.sitemap != blank -%}{{ group.sitemap }}{%- endif -%}{% endfor %}

這些代碼是啥意思啊?

批量添加我會!{{ 'Disallow: /*?q=*' }}再復制一行

不懂的話,直接復制粘貼到我們新建的新建的robots.txt.liquid文件里面。然后,回到網站前端,域名/robots.txt 刷新下。boom

之前我還在想,這次shopify robots.txt更新,可以用這個方法查看網站是否是用shopify搭建,還是太天真了,"# we use Shopify as our ecommerce platform" 這句話,可以編輯修改刪除了,哈哈。

可擴展的玩法好多,比如問候下競爭對手:What's your name? what??What is your name? Tony.?f**k you Tony..? :DDDD

編輯2:Remove a rule from an existing group 從現有組中刪除規則

例如,我們可以使用以下內容刪除阻止爬蟲訪問 /policies/ 頁面的規則:

{% for group in robots.default_groups %}{{- group.user_agent }}{%- for rule in group.rules -%}{%- unless rule.directive == 'Disallow' and rule.value == '/policies/' -%}{{ rule }}{%- endunless -%}{%- endfor -%}{%- if group.sitemap != blank -%}{{ group.sitemap }}{%- endif -%}{% endfor %}

←←←向左滑動代碼←←←

其實,我最想刪除的是,刪除阻止爬蟲訪問 /blog/ 頁面的規則:

代碼如下:

{% for group in robots.default_groups %}{{- group.user_agent }}{%- for rule in group.rules -%}{%- unless rule.directive == 'Disallow' and rule.value == '/blogs/*+*' -%}{{ rule }}{%- endunless -%}{%- endfor -%}{%- if group.sitemap != blank -%}{{ group.sitemap }}{%- endif -%}{% endfor %}

對了,此語法只刪除了第一個Disallow: /blogs/*+*

后面5個,由于不會批量語法,沒刪除掉,

Disallow: /blogs/*%2B*

Disallow: /blogs/*%2b*

Disallow: /*/blogs/*+*

Disallow: /*/blogs/*%2B*

Disallow: /*/blogs/*%2b*

此處流下了沒有代碼技術的汗水,請程序員大佬帶帶我。謝謝!

也不知道,shopify?robots.txt默認阻止爬蟲訪問 /blog/ 頁面的規則,該不該刪除,求SEO大佬解惑。

編輯3:Add custom rules 添加自定義規則

如果要添加不屬于默認組的新規則,則可以在 Liquid 之外手動輸入規則以輸出默認規則。

Block certain crawlers?阻止某些爬蟲

如果爬蟲不在默認規則集中,我們可以手動添加規則來阻止它。例如,以下內容將允許您阻止 discobot 爬蟲:

<!-- Liquid for default rules -->User-agent: discobotDisallow: /

什么時候用?什么時候發現數據被某些非法的或者惡意的爬蟲,爬取網站數據的時候,用!

編輯4:Add extra sitemap URLs添加額外的站點地圖 URL

<!-- Liquid for default rules -->Sitemap: [sitemap-url]

到這里,我還真沒想到Robots.txt協議會引申出這么多內容,比如Robots.txt文件里面的adsbot-google(以后單獨研究下)和Crawl-delay(這次簡單挖挖她)

我理解的,Robots.txt協議其實就是一張菜譜,給饑渴的網絡爬蟲們準備的。

什么是Web Crawler網絡爬蟲呢?

Web Crawler網絡爬蟲,也稱為搜索引擎蜘蛛spider或者機器人bot,是一種自動化軟件,其任務是發現和掃描網頁和資源,目的是在給定的搜索引擎上將它們編入索引。

Googlebot是Google 網絡爬蟲的通用名稱。Googlebot是兩種不同類型爬蟲的總稱:一種是模擬桌面用戶的桌面爬蟲,另一種是模擬移動設備上用戶的移動爬蟲。

蜘蛛訪問任何一個網站的時候,都會先訪問網站根目錄下的Robots.txt文件,如果Robots.txt禁止搜索引擎抓取某些文件或者目錄,蜘蛛將會遵守協議,不抓取被禁止的網址。

比如:?

Disallow: /admin

Disallow: /checkout

Disallow: /carts

Disallow: /orders

什么是網頁爬行?

這是網絡爬蟲自動獲取網頁或資源的過程,目的是在給定的搜索引擎上對其進行索引。

搜索引擎蜘蛛訪問網站頁面時類似于普通用戶使用的瀏覽器,蜘蛛程序發出頁面訪問請求后,服務器返回HTML代碼,蜘蛛程序把收到的代碼存入原始頁面數據庫。

搜索引擎為了提高爬行和crawl rate抓取速度,往往會使用多個蜘蛛并發分布爬行。

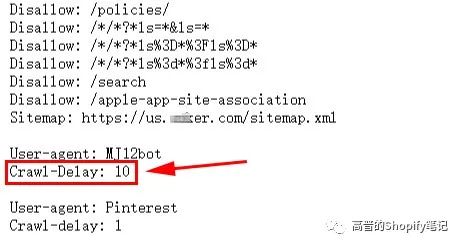

什么是Crawl-Delay抓取延遲?

Crawl-Delay指令是一個非官方指令,旨在與爬蟲通信以減慢爬行速度,以免網絡服務器過載。

其實,有些搜索引擎是不支持 crawl-delay 指令的,并且 crawl-delay 指令的解釋方式因搜索引擎而異。

比如,Google就不支持crawl-delay 指令,如果你想要求谷歌爬得慢一些,你需要在谷歌搜索控制臺中設置crawl rate抓取速度。

如果你的網站無法跟上Google的抓取請求,可以請求更改crawl rate抓取速度。

本篇就不討論如何修改這個值了,作為一般玩家的我也用不到。以后用到的時候再單獨拿出來研究。

"crawl-delay" =?"crawl rate" = 抓取速度

什么是Crawl Rate抓取速度?

抓取速度是指Googlebot在抓取網站時每秒向網站發出的請求次數,例如每秒發出 5 次請求。

我們無法更改Google抓取網站的頻率,但如果希望Google抓取網站上的新內容或更新后的內容,可以請求重新抓取。

抓取速度的正確用法:

Google 采用先進的算法來確定最佳的網站抓取速度。我們的目標是,每次訪問我們的網站時,在不導致服務器帶寬過載的情況下盡可能多地抓取網頁。

如果 Google 每秒向網站發出的請求過多,導致服務器的速度下降,我們可以限制 Google 抓取網站的速度。限制對根級網站(例如 www.example.com 和 http://subdomain.example.com)的抓取速度。設置的抓取速度是 Googlebot 的抓取速度上限。請注意,Googlebot 并不一定會達到這一上限。

除非發現服務器出現負載問題并確定該問題是由于 Googlebot 過于頻繁地訪問我們的服務器導致的,否則不要限制抓取速度。

robots.txt常見的語法

禁止所有搜索引擎訪問網站的幾個部分(下圖中的01、02目錄)

User-agent: *

Disallow: /01/

Disallow: /02/

禁止爬蟲抓取cart、checkout、orders數據還是很好理解把(客戶的隱私,其實搜索引擎拿來沒什么用,不過競爭對手非常喜歡)。不過!為啥默認不讓抓取blog數據,確實有點想不明白,請SEO大佬解惑。

禁止某個搜索引擎的訪問(下例中的AhrefsBot)

User-agent: AhrefsBot

Disallow: /

有關更多robots.txt的語法,請移步《最詳細的robots.txt寫法大全》,以后能找得到現成的、我看得上的中文基礎解釋,就直接引用,省事!

對了,最后來個友情廣告。事情是這樣的。

直接上聯系方式

小點聲:

Bing優勢!現在競爭不大,bid低。

Bing劣勢!有點挑類目。

早布局,早省心!

以上Shopify如何編輯Robots.txt協議文件僅代表個人喜好,僅供參考!

長按下圖二維碼關注,給我留言或加我好友。

為了讓讀者朋友們更加方便地交流和分享,我建立了一個純交流群

(2個公眾號共用這一個群)<高普的SEO筆記>,真誠地邀請各位獨立站的大佬們加入進來,相互交流學習和分享。

PS:服務商朋友勿加(感謝您的理解)

加我微信:valentine06

備注:shopify 進群

如果這篇文章能幫助到您,請點贊、轉發加關注!謝謝您!

"聽說打賞的人,明年別墅靠海喔"

[1].?How to Edit Shopify Robots.txt File

https://increasily.com/how-to-edit-shopify-robots-txt-file/

[2].?Our Top CEOs: Meet 30 Leaders Who Turned Crisis Into Opportunity

https://www.barrons.com/articles/top-ceos-2021-51624667968

[3].?Googlebot

https://developers.google.com/search/docs/advanced/crawling/googlebot

[4].?The ultimate guide to robots.txt

https://yoast.com/ultimate-guide-robots-txt/

[5].?What does crawl-delay: 10 mean in robots.txt?

https://www.contentkingapp.com/academy/robotstxt/faq/crawl-delay-10/

[6].?Change Googlebot crawl rate

https://support.google.com/webmasters/answer/48620

[7].?Discover How Google Search Works

https://www.google.com/search/howsearchworks/

[8].?Editing robots.txt.liquid

https://help.shopify.com/en/manual/promoting-marketing/seo/editing-robots-txt

[9].?Ask Google to recrawl your URLs

https://developers.google.com/search/docs/advanced/crawling/ask-google-to-recrawl

[10].?Hiding a page from search engines

https://help.shopify.com/en/manual/promoting-marketing/seo/hide-a-page-from-search-engines

[11].?Editing robots.txt.liquid

https://help.shopify.com/en/manual/promoting-marketing/seo/editing-robots-txt

[12].?Customize robots.txt

https://shopify.dev/themes/seo/robots-txt

[13].?Discourse (software)

https://en.wikipedia.org/wiki/Discourse_(software)

[14].?Create a robots.txt file

https://developers.google.com/search/docs/advanced/robots/create-robots-txt

[15].?robots.txt.liquid

https://shopify.dev/themes/architecture/templates/robots-txt-liquid

[16].?How to Edit robots.txt on Shopify Stores?

QgB7Y8NNmDw

文章為作者獨立觀點,不代表DLZ123立場。如有侵權,請聯系我們。( 版權為作者所有,如需轉載,請聯系作者 )

網站運營至今,離不開小伙伴們的支持。 為了給小伙伴們提供一個互相交流的平臺和資源的對接,特地開通了獨立站交流群。

群里有不少運營大神,不時會分享一些運營技巧,更有一些資源收藏愛好者不時分享一些優質的學習資料。

現在可以掃碼進群,備注【加群】。 ( 群完全免費,不廣告不賣課!)